¿Qué es un árbol de decisiones y cómo funciona?

17 March, 2025

Compartir este artículo

Tabla de Contenidos

Tomar decisiones no es fácil. Seamos realistas: si la vida tuviera una guía con instrucciones precisas para cada momento clave, la usaríamos sin dudarlo. Pues bien, en el mundo de los datos, esa guía existe y se llama árbol de decisiones.

Si alguna vez leiste un libro de "Elige tu propia aventura" cuando eras niño, ya tienes una idea general de cómo funciona un árbol de decisiones. Este modelo desglosa problemas complejos en pasos más simples y manejables, guiándote hacia una conclusión en función de tus elecciones.

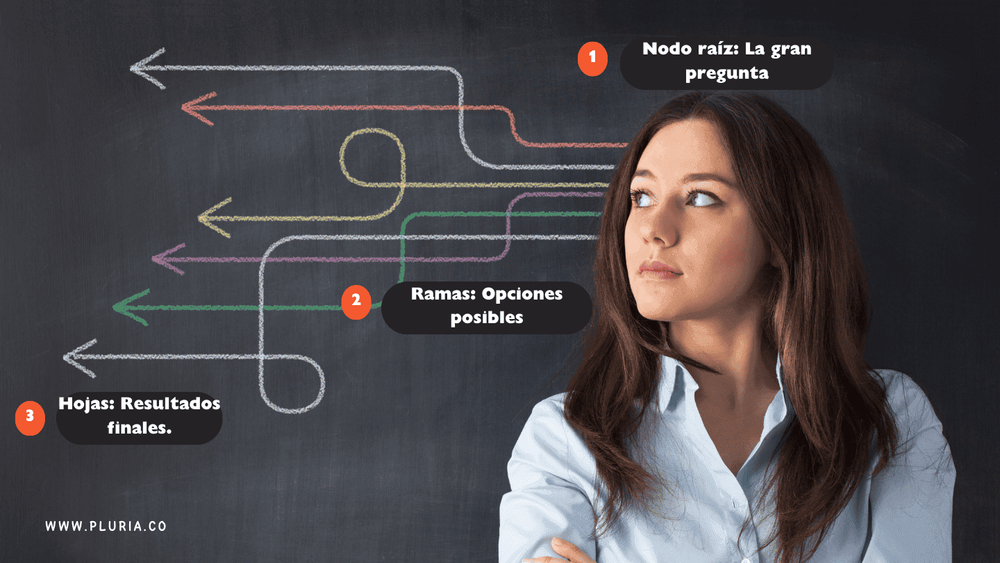

Un árbol de decisiones es básicamente un diagrama de flujo con un propósito claro. Comienza con un nodo raíz (la gran pregunta), se ramifica en diferentes opciones y finaliza en pequeñas hojas que representan los resultados. Se usa en múltiples sectores: las empresas lo aplican para predecir qué comprarán los clientes, los médicos para diagnosticar enfermedades y los bancos para decidir si aprueban un préstamo o no (adiós Lamborghini... en fin).

Photo: © Pluria

Uno de los grandes beneficios de los árboles de decisiones es que son fáciles de entender. A diferencia de esas técnicas avanzadas de modelos de clasificación en aprendizaje automático que parecen magia, los árboles de decisiones muestran la lógica detrás de cada elección.

Pero no son perfectos. A veces pueden volverse demasiado entusiastas y detectar patrones irrelevantes, lo que se conoce como sobreajuste.

Afortunadamente, este problema tiene solución: se puede evitar podiendo el árbol(eliminando partes innecesarias) o utilizando métodos en conjunto de datos, combinando varios árboles para obtener predicciones más precisas.

In this article, we will break down everything you need to know about decision trees: what they are, how they work, and where you can use them.

¿Qué es un árbol de decisiones?

Un árbol de decisiones es un diagrama de flujo que facilita la toma de decisiones. Su función es descomponer un problema complejo en una serie de pasos simples y estructurados. Cada decisión lleva a una nueva rama hasta llegar a un resultado final. Esto lo hace ideales tanto para la toma de decisiones como para la probabilidad de que ocurra un determinado evento en modelos predictivos.

Elementos clave de un árbol de decisiones

- Nodo raíz – El punto de inicio donde se plantea la primera gran pregunta.

- Nodo de decisión –Los puntos donde se toman elecciones basadas en ciertas condiciones.

- Nodos hoja – Representan los resultados finales, donde el proceso de decisión termina.

Photo: © Pluria

Cada ruta desde el nodo raíz hasta una hoja representa un camino diferente para tomar una decisión. Tomemos como ejemplo un diagnóstico médico: un árbol de decisiones comienza con los síntomas (nodo raíz), se ramifica en posibles condiciones médicas (nodos de decisión) y, finalmente, llega a un diagnóstico (nodo hoja)

En el ámbito del modelado predictivo, los árboles de decisiones ayudan a detectar patrones y hacer predicciones basadas en conjuntos de datos históricos. Se utilizan en múltiples áreas, desde la segmentación de clientes (para identificar quien comprará un producto) hasta la evaluación de riesgo crediticio (decidir si aprobar un préstamo) y la detención de fraudes (identificar actividades sospechosas)

¿La mejor parte? Los árboles de decisiones son fáciles de entender e interpretar. A diferencia de ottos modelos complejos de aprendizaje automático, estos muestran claramente cómo se toma una decisión, paso a paso. Por eso siguen siendo una de las herramientas más utilizadas en modelos de clasificación dentro de la ciencia de dato.s

¿Cómo funciona un árbol de decisiones?

Un aárbol de decisiones es una guía paso a paso para tomar decisiones.

Comienza en el nodo raíz, donde se plantea una pregunta inicial. A partir de ahí, el proceso avanza a través de los nodos de decisión, cada uno generando una nueva rama según hasta alcanzar un odo hoja, donde se obtiene el resultado final.

Funcionamiento paso a paso

- Inicio en el nodo raíz– Se plantea una pregunta clave o una condición basada en un aspecto relevante del conjunto de datos.

- Avance a través de los nodos de decisión – En cada paso, se toma una decisión y los datos se dividen en función de la respuesta.

- Repetición hasta llegar a un nodo hoja – El proceso sigue hasta que el modelo alcanza un resultado final.

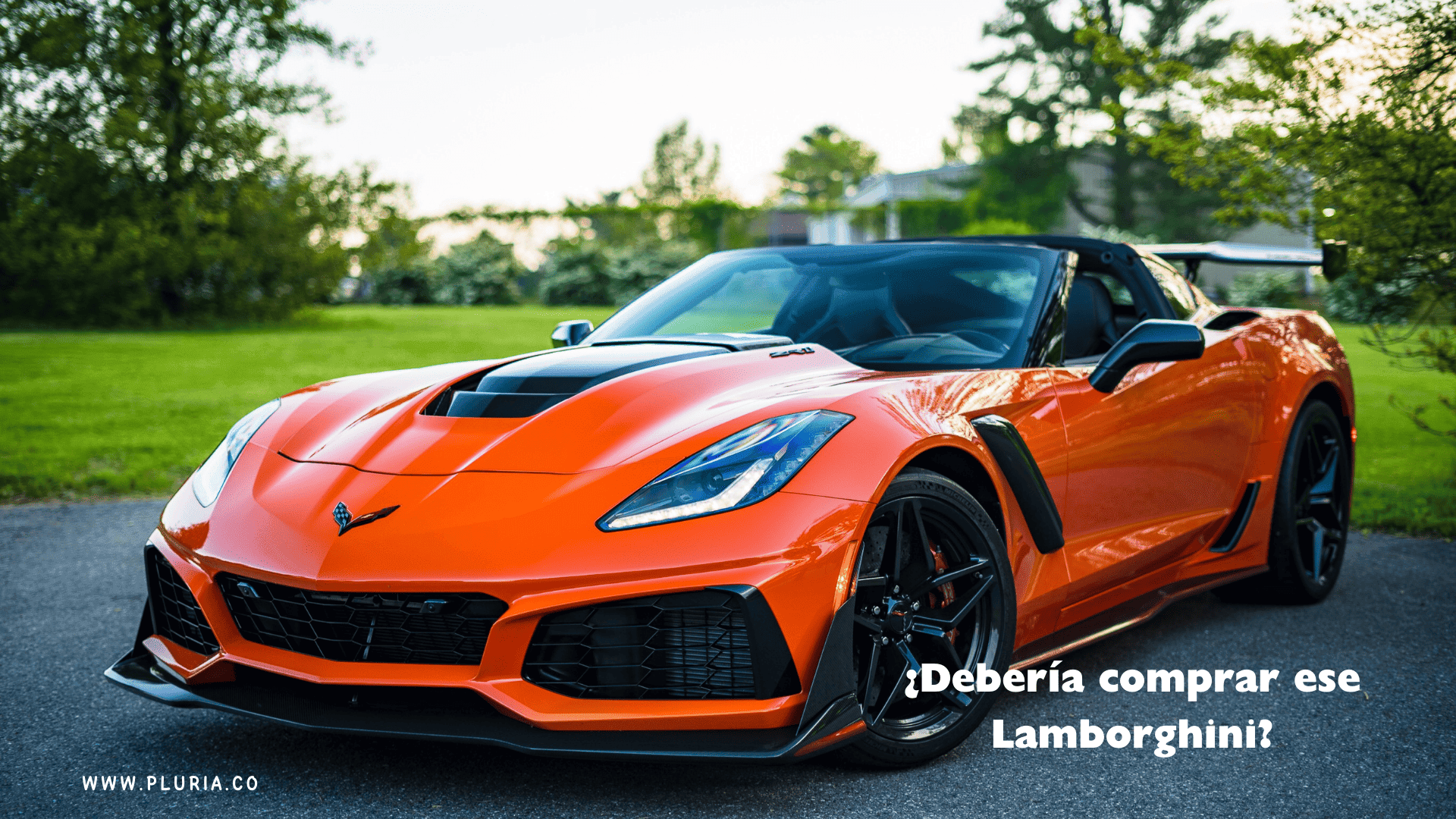

Por ejemplo, imagina que estás dudando si comer chocolate. Un árbol de decisiones podría empezar evaluando tu nivel de antojo: Si es alto, lo comes sin pensarlo. Si es bajo, entran en juego otros factores, como si ya comiste postre o si estás "intentando" reducir el azúcar.

Solo después de analizar estos factores llegas a la decisión final.

Photo: © Pluria

Cómo toma decisiones un árbol de decisiones

En cada nodo de decisión, el modelo elige la mejor manera de dividir los datos según ciertas reglas. Estas reglas pueden ser:

- Numéricas (Edad > 30?) – Separa los dato con base en un valor numérico.

- Categóricas (Tipo de empleo: Asalariado o autónomo?) – Divide según categorías específicas.

El objetivo es lograr la división más pura posible, es decir, que cada rama contenga datos lo más similares entre sí. Para esto, se utilizan técnicas como:

- Impureza de Gini – Mide qué tan "puro" es un grupo después de cada división. Cuanto menor sea la impureza, mejor será la separación.

- Entropía y ganancia de información– Evalúa incertidumbre se elimina tras una división.

Árboles de clasificación vs. árboles de regresión

- Árbol de clasificación –Se utilizan cuando el resultado es una categoría (por ejemplo, "aprobar"' o "Denegar" un préstamo). El árbol organiza los datos en grupos predefinidos.

- Árboles de regresión – Se utilizan cuando el resultado es un valor continuo (por ejemplo, la predicción de precios de viviendas). En lugar de categorías, el árbol calcula resultados numéricos.

Los árboles de decisión son simples pero poderosos, por lo que son una opción popular para la toma de decisiones y el modelado predictivo en cualquier negocio.

Tipos de árboles de decisiones

Los árboles de decisiones pueden dividirse en dos tipos principales según el problema que resuelven:

Árboles de clasificación

Se utilizan cuando el resultado es una categoría (por ejemplo, "Aprobar" o "Denegar" un préstamo). En este caso, el árbol agrupa los datos en categorías predefinidas.

Un ejemplo clásico es el filtro de spam de los correos electrónicos. Un árbol de clasificación analiza factores como las palabras clave, la dirección del remitente y el número de enlaces en un correo. Con base a estos datos, determina si el mensaje es "Spam" o "No spam"

Así funciona un árbol de clasificación:

- Identifica la característica más relevante para dividir los datos.

- Continúa separando la informacion en cada nodo de decisión, agrupando los casos de la forma más precisa posible.

- Llega a una categoría final en un nodo hoja, cuando se cumplen todas las condiciones.

El resultado es un modelo que aprende de los patrones en los datos y asigna correctamente nuevas instancias a la categoría adecuada.

Árboles de regresión

A diferencia de los árboles de clasificación, un árbol de regresión no predice una categoría, sino un valor númerico.

Por ejemplo, en lugar de decir si un correo es "Spam" o "No spam", un árbol de regresión podría predecir el precio de una casa o la probabilidad de que ocurra un evento específico.

Imagina que estás eligiendo un postre. Un árbol de regresión evaluaría factores como tu nivel de hambre, los dulces que tienes disponibles y si prefieres algo como chocolates o frutas. A partir de estas variables, el modelo te guiaría paso a paso hasta la mejor opción de postre.

Photo: © Pluria

Diferencia clave

- Los árboles de clasificación predicen categorías (por ejemplo, "Sí" o "No").

- Los árboles de regresión predicen valores numéricos (por ejemplo, el precio de una casa de $250,000)

Ambos tipos siguen la misma lógica, pero están diseñados para resolver diferentes tipos de problemas.

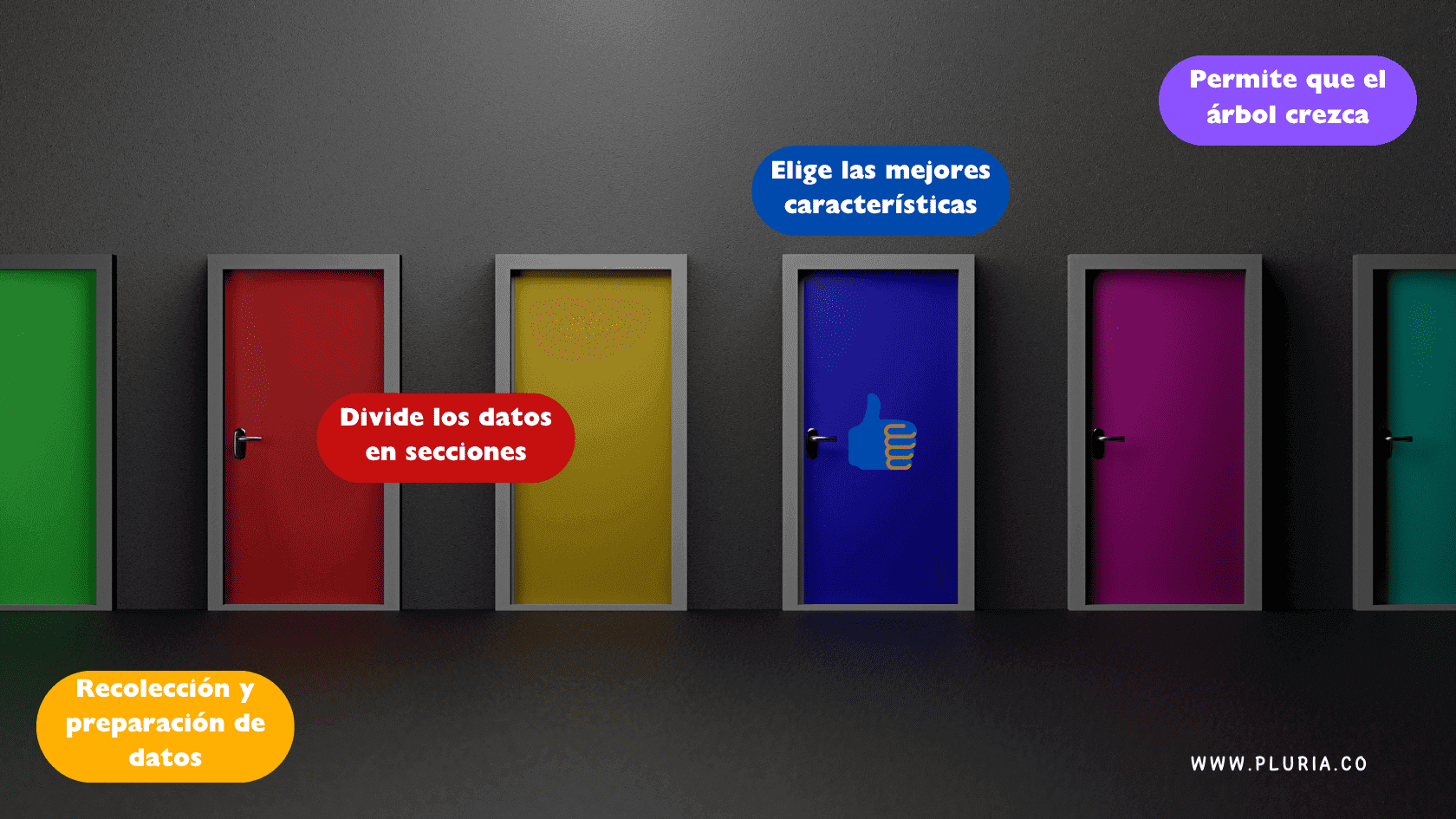

Pasos para construir un árbol de decisiones

La creación de un árbol de decisiones es un proceso que convierte datos en bruto en un modelo capaz de tomar decisiones. Así es como funciona, desde el inicio hasta el final.

1. Recolección y preparación de datos

Para obtener buenos resultados, necesitas datos de calidad. No importa qué tan avanzado sea el modelo: si los datos son deficientes, las predicciones también lo serán. Esta etapa incluye:

- Reunir datos relevantes y de alta calidad

- Manejar valores faltantes (porque los datos del mundo real casi nunca están completos

- Convertir categorías en valores numéricos si es necesario.

- Normalizar datos numéricos cuando sea requerido (aunque los árboles de decisiones generalmente no necesitan mucho ajuste).

Un conjunto de datos limpio y bien organizado es la base de un buen árbol de decisiones

2. Elegir las mejores características

En cada paso, el árbol debe decidir qué variable usar para dividir los datos. Las opciones más relevantes se seleccionan mediante:

- Ganancia de información, mide la reducción de incertidumbre tras una división (usado en problemas de clasificación)

- Índice de Gini, Evalúa qué tan "puro" es un conjunto después de dividirlo (un valor más bajo indica una mejor separación

El objetivo es centrarse en las características más importantes para tomar las mejores decisiones.

3. Dividir los datos en secciones

Una vez seleccionada la mejor variable, el conjunto de datos se divide en subgrupos. Cada nueva división agrega un punto de decisión, refinando la clasificación o predicción.

Por ejemplo, si un árbol de decisiones predice la fuga de clientes, podría dividir primero según el tiempo de suscripción, luego evaluar el nivel de actividad y, finalmente, analizar las interacciones con soporte para determinar si un cliente cancelará su servicio.

4. Dejar crecer el árbol (pero no mucho)

El modelo repite continuamente la tarea de división de datos y selección de características hasta llegar a un punto de finalización. Sin embargo, es importante evitar que crezca demasiado, ya que esto puede generar sobreajuste y hacer que el árbol detecte ruido en lugar de patrones reales,

Algunas reglas para evitar que el modelo se vuelva demasiado complejo incluyen

Some stop rules include:

- Profundidad máxima. Evita que el árbol se vuelva excesivamente complicado.

- Muestras mínimas por nodo. Garantiza que cada división realmente aporte valor y no se base en un conjunto de datos muy pequeño.

- Sin divisiones útiles adicionales. Si dividir más no mejora la precisión, el árbol deja de crecer.

Photo: © Pluria

Un buen árbol de decisiones es como un detective: profundiza lo suficiente para encontrar patrones reales, pero sabe cuándo detenerse antes de empezar a ver pistas que en realidad no existen.

Algoritmos populares de árboles de decisiones

A lo largo del tiempo, se han desarrollados diferentes algoritmos de árboles de decisiones para hacerlos más inteligentes, rápidos y precisos. Los más utilizados son ID3, C4.5, C5.0 y CART, cada uno con su propia forma de manejar distintos tipos de conjuntos de datos.

1. ID3 (Iterative Dichotomiser 3)

ID3 fue uno de los primeros algoritmos de árboles de clasificación, creado por Ross Quinlan. Se usa principalmente en problemas donde el objetivo es clasificar datos en categorías y selecciona la mejor variable para dividir el conjunto de datos utilizando entropía y ganancia de información (es decir, elige la característica que reduce más la incertidumbre en cada paso).

- Bueno para: Conjuntos de datos pequeños con variables categóricas.

- No tan bueno para: No maneja bien variables numéricas y tiende a sobreajustarse a los datos.

Photo: © Pluria

2- C4.5 y C5.0

C4.5 es una versión superior del ID3 que puede trabajar con datos categóricos y numéricos. Además, incluye diferentes mejoras clave:

- Gestiona valores faltantes sin necesidad de descartar datos.

- Optimiza el árbol eliminando ramas innecesarias y evitando el sobreajuste.

- Convierte el árbol en un modelo basado en reglas, haciéndolo más fácil de interpretar

C5.0 lleva estas mejoras aún más lejos, ofreciendo modelos más rápidos, eficientes y precisos.

3. CART (Classification and Regression Trees)

CART es un algoritmo versátil que se adapta tanto a modelos de clasificación como de regresión. A diferencia de ID3 y C4.5, que usan entropía, CART se basa en:

- Índice de Gini para clasificación (para medir qué tan "pura" es una división).

- Error cuadrático medio (MSE) para regresión (para encontrar la mejor separación numérica).

- Ideal para: Grandes conjuntos de datos, tanto numéricos como categóricos, y funciona bien con poda.

- Limitaciones: Si no se poda adecuadamente, puede generar árboles demasiado profundos y propensos al sobreajuste.

Cada uno de estos algoritmos tiene sus debilidades y fortalezas, pero todos ayudan a que los árboles de decisiones sean más eficientes acorde a el tipo de problema que se quiera resolver.

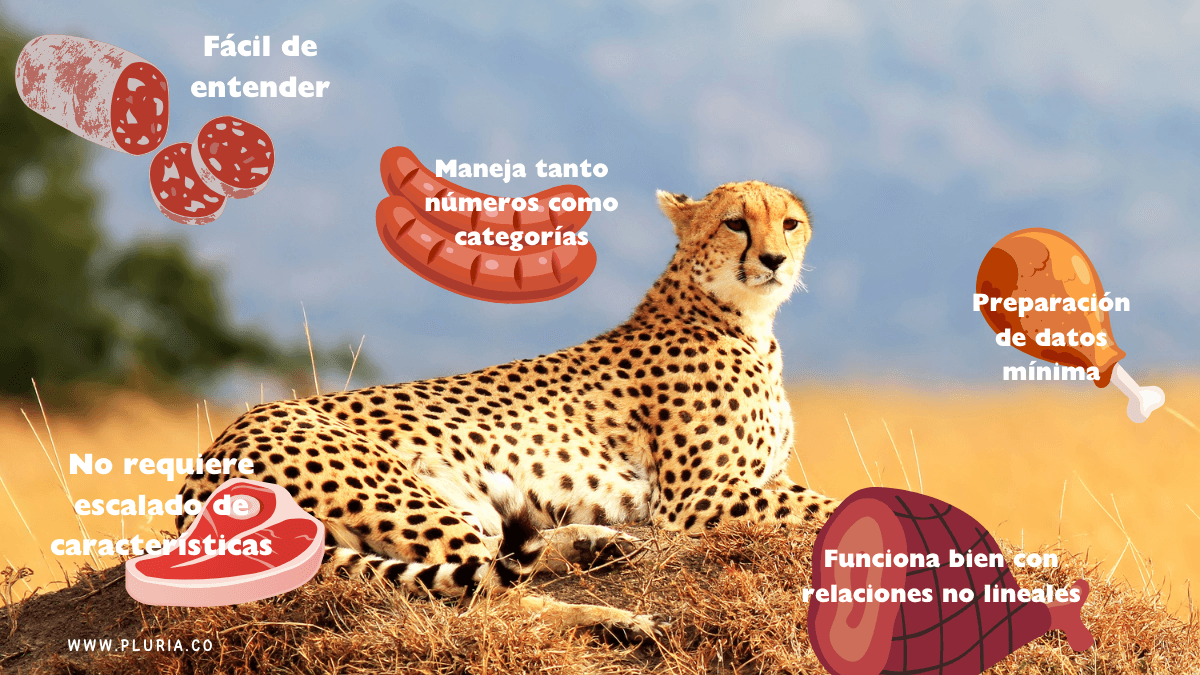

Ventajas y desventajas

Los árboles de decisiones son herramientas sencillas y flexibles: requieren poca configuración y pueden manejar diferentes tipos de conjuntos de datos. Sin embargo, también presentan algunos inconvenientes, ya que pueden volverse demasiado complejos, ser muy sensibles a pequeños cambios y tener dificultades con grandes volúmenes de datos si estos no se gestionan bien.

Ventajas de los árboles de decisiones

Photo: © Pluria

Fáciles de entender. Su estructura en forma de diagrama de flujo los hace intuitivos y fáciles de explicar, incluso para personas sin conocimientos técnicos.

- No requieren escalado de características. A diferencia de otros modelos de clasificación, los árboles de decisiones no se ven afectados por si los datos tienen escalas diferentes; no es necesario normalizar ni estandarizar.

- Manejan datos numéricos y categóricos. Ya sea que los datos sean numéricos (edad, ingresos) o categóricos (color, tipo de empleo), los árboles de decisiones pueden trabajar con ambos tipos sin problemas.

- Preparación mínima de datos. No necesitas invertir largas horas en limpieza y transformación de datos; los árboles de decisiones pueden procesar información en bruto mejor que muchos otros modelos.

- Funcionan bien con relaciones no lineales. A diferencia de los modelos lineales, los árboles de decisiones pueden detectar patrones complejos e interacciones entre características sin necesidad de ajustes matemáticos adicionales.

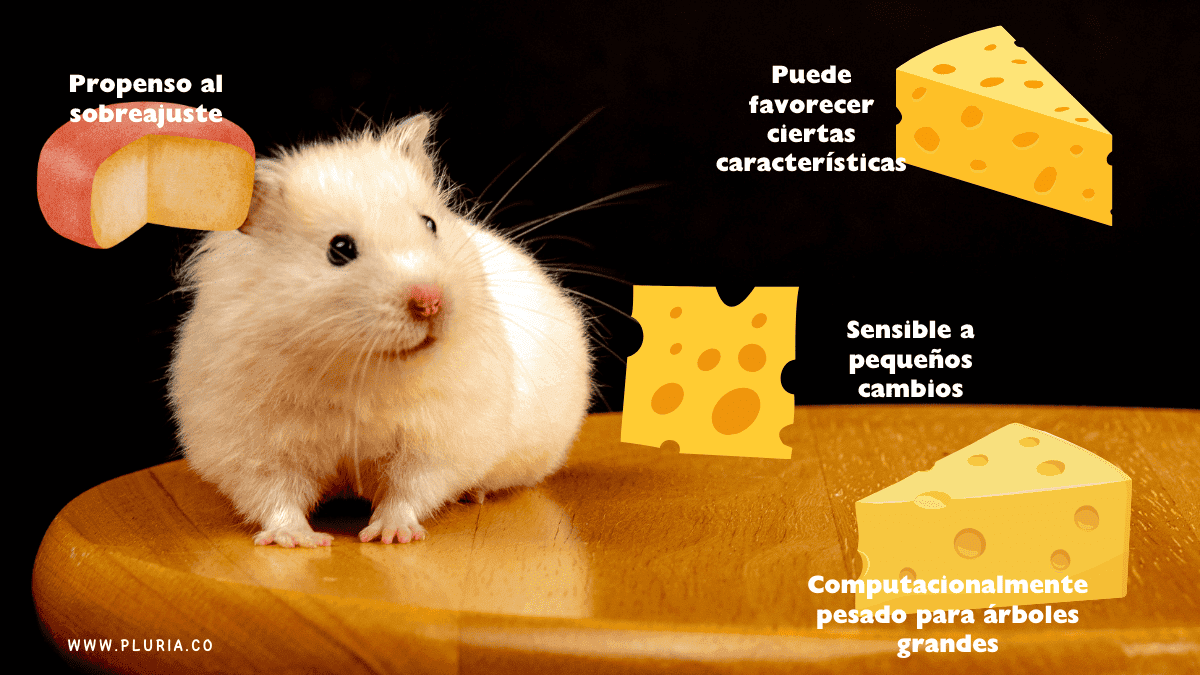

Desventajas de los Árboles de decisiones

- Propensos al sobreajuste. Si un árbol de decisiones crece demasiado, comienza a memorizar el conjunto de datos en lugar de aprender patrones reales, lo que dificulta su capacidad para generalizar nuevos datos. Para evitarlo, se recomienda aplicar poda o usar métodos en conjunto como Random Forest.

- Sensibles a pequeños cambios. Una leve modificación en los datos puede alterar completamente la estructura del árbol, lo que los hace menos estables que otros modelos.

- Pueden favorecer ciertas características. Si algunas variables tienen muchos valores distintos, el árbol podría depender demasiado de ellas, generando decisiones sesgadas.

- Demandantes en términos computacionales. A medida que el conjunto de datos crece, entrenar un árbol profundo puede consumir mucho tiempo y memoria, lo que dificulta su escalabilidad.

Photo: © Pluria

Bien, ahora pongamos esto más divertido

Los árboles de decisiones tienen sus particularidades, pero siguen siendo una herramienta clave en clasificación y aprendizaje automático. Con los ajustes adecuados, pueden pasar de ser modelos básicos a soluciones realmente poderosas.

Árboles de decisiones vs. otros modelos de aprendizaje

Los árboles de decisiones ahora son solo uno de los competidores en la pista del machine learning, donde cada modelo tiene sus propias fortalezas y debilidades.Pero, ¿Cuándo destacan? Pongámoslos frente a regresión logística, random forests y redes neuronales para ver quién se lleva el título.

Árboles de decisiones vs. regresión logística

- Regresión logística: Es como ese amigo que solo piensa en líneas rectas. Funciona bien para clasificación binaria, pero asume que la relación entre variables es sencilla y directa.

- Árboles de decisiones: No se preocupan por las líneas rectas. Son más flexibles y pueden manejar relaciones no lineales y patrones complejos con facilidad.

Cuándo elegir un árbol de decisiones: Si tu conjunto de datos tiene relaciones no lineales, múltiples interacciones entre variables o una mezcla de datos categóricos y numéricos, el árbol es tu mejor opción.

Árboles de decisiones vs. random Forests

- Random forests: Son como un árbol de decisiones con refuerzos. Combinan múltiples árboles para mejorar la precisión y evitar el sobreajuste.

- Árboles de decisiones: Van en solitario. Son más simples y rápidos, pero pueden sobreajustarse cuando los datos se vuelven demasiado complejos.

Cuándo elegir un árbol de decisiones: Si buscas interpretabilidad y trabajas con un conjunto de datos pequeño, un árbol de decisiones puede ser la mejor opción. Su estructura clara facilita la comprensión de los resultados sin añadir complejidad innecesaria.

Árboles de decisiones vs. redes neuronales

- Redes neuronales: Son expertas en encontrar patrones complejos, los grandes del machine learning. pero necesitan grandes volúmenes de datos y mucha potencia computacional.

- Árboles de decisiones: Fáciles de entender y menos exigentes con los datos, aunque pueden quedarse cortos en problemas con muchas variables.

Cuándo elegir un árbol de decisiones: Cuando necesites un modelo que justifique cada decisión de forma clara. Son ideales para datos estructurados y análisis interpretables. En cambio, si trabajas con reconocimiento de imágenes o procesamiento de lenguaje natural, las redes neuronales serán una mejor opción, ya que manejan mejor los patrones complejos.

Photo: © Pluria

¿Cuando es un árbol de decisiones la mejor opción?

- Cuando realmente quieres entender lo que hace tu modelo: reglas de decisión claras, sin magia de caja negra.

- Cuando trabajas con un conjunto de datos pequeño o mediano y no necesitas un monstruo computacional.

- Cuando tus datos se ríen en la cara de las relaciones lineales.

- Cuando prefieres pasar menos tiempo limpiando y ajustando datos y más tiempo obteniendo resultados.

Los árboles de decisiones quizás no siempre encabecen los rankings de precisión, pero siguen siendo una de las herramientas más valiosas en aprendizaje automático, especialmente cuando la claridad y la estructura importan más que exprimir hasta la última décima de precisión.

Casos de estudios y aplicaciones en el mundo real

Los árboles de decisiones son favoritos en muchas industrias porque son fáciles de entender, eficientes y excelentes para simplificar decisiones complejas. Aquí es donde realmente brillan:

Toma de decisiones en negocios

Las empresas usan árboles de decisiones para afinar estrategias, predecir el comportamiento de los clientes y mantener las operaciones funcionando sin problemas. Algunos usos reales:

- Marketing: Identificar qué clientes tienen más probabilidades de engancharse con una campaña.

- Atención al cliente: Clasificar quejas como un profesional y encontrar la mejor solución.

- Cadena de suministro: Determinar cuánto inventario almacenar sin terminar con un almacén lleno de arrepentimientos.

Salud y diagnóstico médico

Los médicos recurren a los árboles de decisiones para diagnosticar enfermedades y recomendar tratamientos en función de síntomas e historial médico. Algunos ejemplos:

- Detección de cáncer: Evaluar el tamaño del tumor, la edad del paciente y los marcadores genéticos para analizar el riesgo de cáncer.

- Predicción de enfermedades: Estimar la probabilidad de padecer afecciones como enfermedades cardíacas con base en pruebas médicas y factores de estilo de vida.

Los árboles de decisiones ayudan a estandarizar y agilizar la toma de decisiones médicas, proporcionando a los doctores un método claro y basado en datos para analizar casos, porque la improvisación no tiene lugar en la medicina.

Finanzas y seguros

Los bancos y las aseguradoras confían en los árboles de decisiones para detectar fraudes y evaluar riesgos. Así los utilizan:

- Puntajes de crédito: Decidir si alguien es una apuesta segura para un préstamo con base en sus ingresos, historial crediticio y nivel de deuda.

- Fraude en seguros: Identificar reclamaciones sospechosas analizando patrones de fraudes anteriores.

- Ciberseguridad: Detectar transacciones inusuales que no coinciden con el comportamiento habitual del usuario.

Cuando el dinero está en juego, los árboles de decisiones ayudan a las instituciones financieras a tomar decisiones más inteligentes, rápidas y seguras.

Photo: © Pluria

Puntos claves

- Flexibles y de bajo mantenimiento: Los árboles de decisiones pueden trabajar con datos categóricos y numéricos sin requerir un procesamiento previo excesivo.

- Versátiles y prácticos: Son especialmente útiles en la toma de decisiones empresariales, diagnósticos médicos y detección de fraudes.

- No son perfectos, pero tienen solución: Pueden sobreajustarse y ser sensibles a cambios en los datos, pero técnicas como la poda y los métodos en conjunto (te estamos viendo, Random Forest) ayudan a controlarlos.

Siguientes pasos

Si quieres ver los árboles de decisiones en acción, ¿por qué no construir uno por tu cuenta? Librerías como scikit-learn en Python hacen que sea fácil crear y entrenar modelos de árboles de decisión. Experimenta con distintos conjuntos de datos, ajusta parámetros y observa cómo el árbol se divide y crece. Es la mejor manera de entender realmente cómo funcionan en la práctica.

Mantente al día con nuestros artículos más recientes, eventos y todo lo que Pluria tiene para ofrecerte.

Al suscribirte al boletín, aceptas la política de privacidad

Un movimiento masivo hacia el trabajo híbrido

En 2022, el 60% de las empresas cambiará a un modelo de trabajo híbrido, y un tercio de ellas fracasará en su primer intento de tra[...]

08 February, 2024

Cuando en la empresa más innovadora del planeta los empleados se unen contra el CEO porque este los quiere en la oficina tres días a la semana, es [...]

08 February, 2024

En el dinámico mundo laboral actual, la mentalidad de crecimiento, que asume que las habilidades e inteligencia se pueden desarrollar con esfuerzo y aprendizaje, se ha convertido en clave pa[...]

23 December, 2024